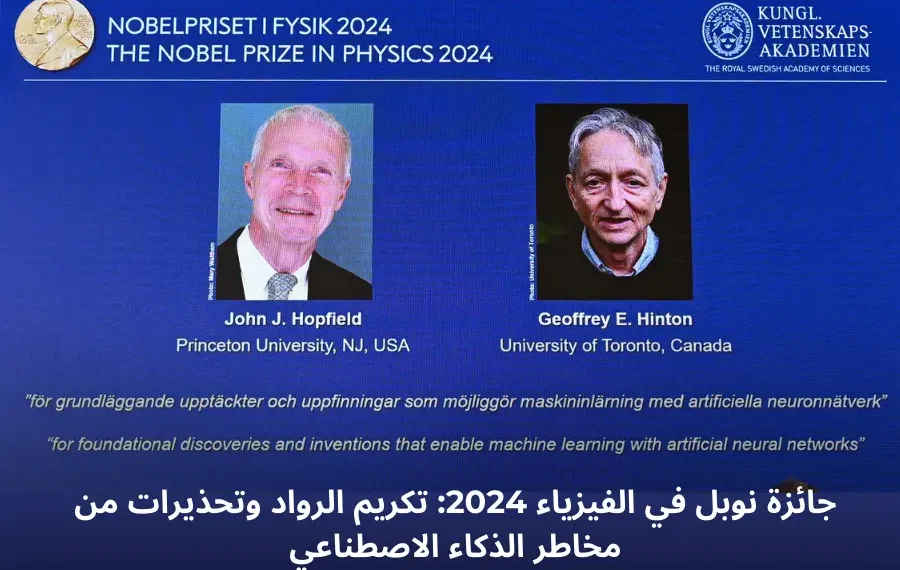

في إنجاز علمي غير مسبوق، مُنحت جائزة نوبل في الفيزياء لعام 2024 للعالمين جون هوبفيلد وجيفري هينتون تقديراً لأبحاثهما الرائدة في مجال الذكاء الاصطناعي وتطوير الشبكات العصبية الاصطناعية، ومع ذلك أثار هوبفيلد تحذيرات جدية بشأن المخاطر المحتملة لتطور هذه التكنولوجيا إذا لم يتم ضبطها بشكل صحيح.

تطور الذكاء الاصطناعي: من الخيال إلى الواقع

أكدت لجنة جوائز نوبل أن العالمين هوبفيلد وهينتون قد أحدثا تحولاً جذرياً في أنظمة التعلم الآلي، التي تعتمد على الشبكات العصبية الاصطناعية، حيث تمتد تطبيقات هذه الأبحاث لتشمل العديد من المجالات، بما في ذلك:

- فيزياء الجسيمات

- علوم المواد

- الفيزياء الفلكية

قالت رئيسة لجنة نوبل للفيزياء، إلين مونز، إن هوبفيلد وهينتون قدما ابتكارات أساسية ساعدت على بناء أنظمة ذكاء اصطناعي قادرة على معالجة كميات هائلة من البيانات، وبفضل هذه التقنيات، أصبحت الشبكات العصبية جزءًا لا يتجزأ من حياتنا اليومية، حيث تُستخدم في مجموعة متنوعة من التطبيقات التي تشمل التعرف على الصور، معالجة اللغات الطبيعية، وغيرها من التقنيات الذكية.

كما أن هذا التقدم العلمي قد شكّل الأساس لأنظمة التعلم الآلي القوية التي نعتمد عليها في حياتنا اليومية، من تطبيقات الهواتف الذكية إلى الذكاء الاصطناعي المستخدم في الصناعات الحديثة.

تحذيرات جون هوبفيلد: مخاوف من كارثة محتملة

على الرغم من هذا التقدم، أعرب جون هوبفيلد، الذي يبلغ من العمر 91 عامًا، عن قلقه العميق بشأن مخاطر التقدم التكنولوجي في الذكاء الاصطناعي، وقال هوبفيلد في كلمة له عبر الفيديو من بريطانيا أمام جامعة نيوجيرسي، إن التقدم السريع في هذه التقنية قد يؤدي إلى كارثة إذا لم يُفهم جيداً.

وأشار هوبفيلد إلى أن العالم شهد من قبل ظهور تقنيات خطيرة مثل الهندسة البيولوجية والفيزياء النووية، والتي تحمل إمكانيات هائلة، ولكن قد تكون ذات نتائج كارثية إذا لم يتم التحكم بها بشكل صحيح. وأضاف:

“نحن معتادون على التقنيات التي قد تكون جيدة أو سيئة في نفس الوقت، لكن الذكاء الاصطناعي يُثير تساؤلات حول قدرتنا على السيطرة عليه.”

الشبكات العصبية الاصطناعية: قدرات غير محدودة ولكن مقلقة

أكد هوبفيلد أن الشبكات العصبية الاصطناعية، التي تبدو كأنها “عجائب تقنية”، لا تزال غير مفهومة بالكامل، وأضاف أن هذا الجهل قد يؤدي إلى نتائج غير مرغوبة في المستقبل، وأننا بحاجة إلى فهم أعمق لكيفية عمل هذه الأنظمة لمنعها من الخروج عن السيطرة.

الخوف من المستقبل: سباق محموم بين الشركات

أوضح هوبفيلد أن التسارع الكبير الذي تشهده الشركات في تطوير تقنيات الذكاء الاصطناعي قد يتجاوز قدرة العلماء على استيعابها والسيطرة عليها، متوقعاً ظهور “قدرات تفوق ما يمكن تصوره حالياً”، محذراً من أن هذا التطور السريع قد يسفر عن عواقب غير متوقعة.

مثال من الخيال العلمي: قصة آيس-ناين

استشهد هوبفيلد بقصة خيالية من رواية “مهد القطة” للكاتب كورت فونيغوت، حيث تم تطوير مادة تسمى آيس-ناين لأغراض عسكرية، لكنها أدت إلى كارثة بيئية وتسببت في تصلّب المحيطات وتدمير الحضارة، وأعرب هوبفيلد عن مخاوفه قائلاً:

“أنا أقلق من أي شيء يتميز بسرعة التطور التي تفوق قدرتنا على التحكم فيه.”

أهمية الفهم والضبط

أكد هوبفيلد أن تطوير تقنيات الذكاء الاصطناعي يجب أن يتم بحذر شديد، مع ضرورة تحقيق فهم أعمق لطريقة عملها، فالقدرات الهائلة التي تقدمها هذه التكنولوجيا قد تحمل في طياتها عواقب غير متوقعة إذا لم يتم التحكم بها بشكل جيد.

الفائزون بجائزة نوبل للفيزياء: العقد الأخير

إليك قائمة بأسماء الفائزين بجائزة نوبل في الفيزياء خلال السنوات العشر الماضية:

- 2024: جيفري هينتون (الولايات المتحدة) وجون هوبفيلد (المملكة المتحدة/كندا)

- 2023: بيار أغوستيني (فرنسا)، فيرينس كراوس (النمسا/المجر)، وآن لويلييه (فرنسا/السويد)

- 2022: آلان أسبيه (فرنسا)، جون كلاوسر (الولايات المتحدة)، وأنتون زيلينغر (النمسا)

- 2021: شوكورو مانابي (الولايات المتحدة/اليابان)، كلاوس هاسلمان (ألمانيا)، وجورجيو باريزي (إيطاليا)

- 2020: راينهارد غنزل (ألمانيا)، روجر بنروز (بريطانيا)، وأندريا غيز (الولايات المتحدة)

- 2019: ميشال مايور وديدييه كيلو (سويسرا)، جيمس بيبلز (كندا/الولايات المتحدة)

- 2018: آرثر آشكين (الولايات المتحدة)، جيرار مورو (فرنسا)، ودونا ستريكلاند (كندا)

- 2017: وراينر فايس (الولايات المتحدة)، باري باريش، كيب ثورن

- 2016: ديفيد ثاوليس، ف. دانكن هولداين، وج. مايكل كوستيرليتس (بريطانيا)

- 2015: تاكاكي كاجيتا (اليابان)، آرثر ب. ماكدونالد (كندا)

الذكاء الاصطناعي بين الفرص والمخاطر

يظل الذكاء الاصطناعي سلاحًا ذو حدين؛ فهو يفتح آفاقًا جديدة للتطور التكنولوجي، لكنه يحمل في طياته مخاطر كبيرة إذا لم يتم ضبطه بشكل صحيح، وبينما يحتفل العالم بتكريم الرواد في هذا المجال، يجب أن تظل الحاجة إلى فهم أعمق وضبط هذا التقدم في مقدمة الأولويات.